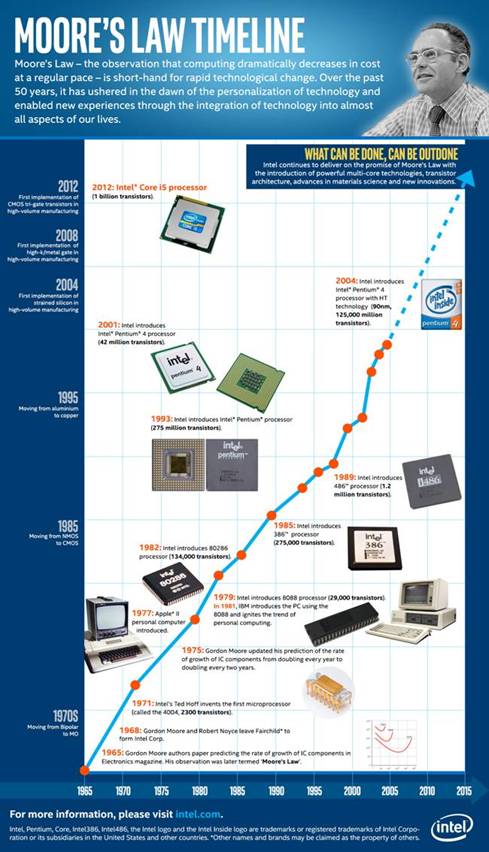

L’histoire commence en 1965. Gordon Moore, ingénieur américain spécialiste du domaine des semi-conducteurs – et futur co-fondateur de la firme Intel – fait le constat selon lequel le nombre de transistors regroupés sur un même circuit intégré croît de façon exponentielle depuis plusieurs années. Il publie ces observations dans la revue Electronics, dans un article où il affirme qu’au cours des dix prochaines années, le nombre de ces composants électroniques sera amené à doubler tous les dix-huit mois (la durée fut par la suite portée à deux ans), le tout pour un coût économique et énergétique sensiblement identique. La fameuse « loi de Moore » était née.

De façon incroyable, cette loi empirique est restée valable depuis son énoncé. Si elle résulte principalement des progrès de la recherche et de la technologie de production industrielle des semi-conducteurs, cette conjecture a surtout servi de fil conducteur de la productivité et de la politique d'innovation des entreprises du secteur de l'électronique, friand de circuits intégrés. Une sorte de prophétie économique auto-réalisatrice, en somme.

En amont, chez les industriels du semi-conducteur, l’amélioration continue de la finesse de gravure de ces transistors, conduit à leur miniaturisation de plus en plus poussée, ce qui permet de faire grimper le nombre d’éléments qu’il est possible de placer sur une même puce. De 2300 transistors en 1971 sur le premier processeur 4004 d’Intel, on atteint le chiffre record d’1,5 milliard, à l’instar du dernier Core i5 de cinquième génération d’Intel…

Et bien sûr, il en résulte une amélioration significative des performances de calcul et de rapidité de nos ordinateurs, smartphones et autres dispositifs modernes. La courbe ci-dessous, réalisée par la firme Intel, traduit bien cette formidable et impressionnante montée en puissance au cours des années.

La loi de Moore fournit un horizon commun au marché de l'électronique et à ses applications : l'augmentation « prévisible » des performances à coût constant, permet aux industriels d'innover sans cesse et de créer chez les utilisateurs un besoin de renouvellement régulier de leurs équipements, au gré des nouvelles fonctionnalités offertes. Un bon moyen pour les grandes firmes du numérique de s’assurer des bénéfices financiers permanents. Avec de surcroît un appétit sans limite pour la rapidité, la connectivité immédiate, partout, avec tout le monde. Pendant un temps, ce sont les jeux vidéo qui ont dopé les performances attendues de la micro-informatique, maintenant c'est la vidéo en ligne, le big data, etc.

Mais si elle semble avoir atteint aujourd’hui son apogée, la loi pourrait prochainement arriver à ses limites. En effet, la miniaturisation à l’infini n’est pas possible. En cause : des problèmes techniques de dissipation de chaleur et de consommation énergétique ou bien tout simplement la barrière de la taille atomique. Les alternatives aux semi-conducteurs semblent se cantonner pour le moment à des prouesses de laboratoires. Autre frein de taille, les investissements dans les usines de production de puces, qui se chiffrent en dizaines de milliards de dollars, pour chaque nouvelle génération.

Aurait-on atteint la fin du progrès technologique ? Gordon Moore lui-même a annoncé ne pas savoir combien de temps encore son principe resterait d’actualité. Une incertitude qui ne semble pas inquiéter Intel : la firme continue de travailler à l’optimisation de l’architecture de ses transistors, à la performance énergétique de ses processeurs « multi-core », ou encore à l’exploitation du désormais bien connu Big Data.